环境遥感与数字城市北京市重点实验室2020年开放课题优秀成果展示1

发布日期:2021-11-28 | 浏览次数:

基于多源多尺度遥感影像的建筑物语义信息提取研究

课题负责人: 徐朋磊 课题成员:黄伟 指导教师:唐宏

遥感影像智能解译是一种提取建筑物的有效方法。随着成像技术的发展,遥感数据的空间分辨率逐渐提升,我们能从中提取出来的建筑物也更加精细化。例如,像MODIS数据一样的百米级或者十米级影像常用来识别地球表面的大尺度建成区。而像WorldView或QuickBird这种米级或亚米级的数据则可以将单栋建筑物提取出来。但是在实际的应用场景中(防震减灾,灾损评估),我们难以快速获取高分辨率的数据,也就难以进行单栋建筑物级别的识别。而一些有着低空间分辨率的数据往往可以很快地从开放平台上免费获取,如哨兵2号数据。如果这些公开数据可以被用于生产精细的建筑物语义图,那么高分数据的获取困境将得到有效缓解。超分辨率语义分割(SRSS)则是实现从低分数据提取高分语义图的有效方法。

|

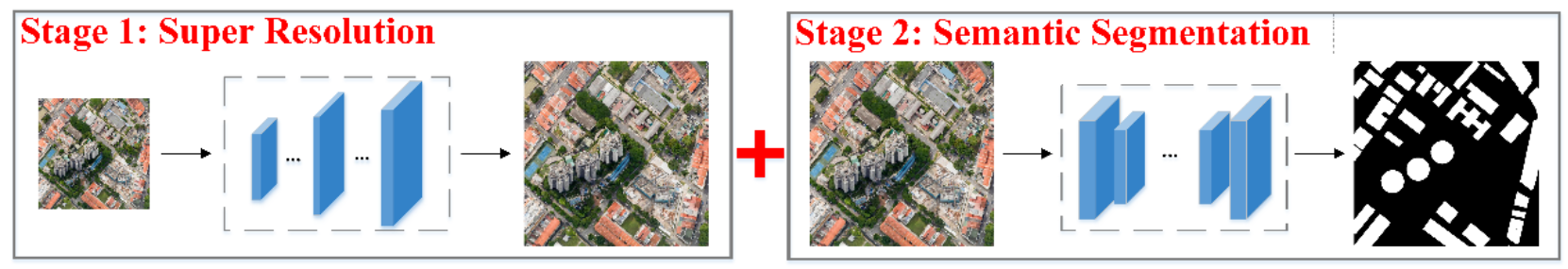

(a) 分阶段方法 |

|

(b) 端到端方法 |

图1 SRSS的简要结构 |

目前有两种SRSS方法:(1) 将图片超分辨率和语义分割独立训练的分阶段方法如图1(a),技术相对成熟;(2) 将超分辨率和语义分割融合到一起的端到端方法如图1(b),目前该种方法的相关研究较少。在本文中,我们提出了一种端到端的SRSS网络,即ESPC_NASUnet。

(一) 实验数据

DREAMB数据集:包含626张来自全球100个不同城市的遥感图片,其中250张用于训练,63张用于验证,剩下的313张用于测试。每个图片的原始尺寸是![]() ,空间分辨率为0.3米。为了满足超分辨率语义分割的需求,使用BiCubic方法将所有图片重采样到

,空间分辨率为0.3米。为了满足超分辨率语义分割的需求,使用BiCubic方法将所有图片重采样到![]() 以模拟1.2米的空间分辨率。

以模拟1.2米的空间分辨率。

马萨诸塞州建筑物数据集:原始的数据集中包含151张来自美国马萨诸塞州的无人机影像和对应的建筑物标注,其中137张用于训练,4张用于验证,10张用于测试。影像的原始空间分辨率是1米,像素大小是![]() 。和上个数据集一样,这些图片也被BiCubic方法重采样到

。和上个数据集一样,这些图片也被BiCubic方法重采样到![]() 以模拟4米空间分辨率的数据。

以模拟4米空间分辨率的数据。

这两个数据集中的影像都仅包含了红、绿和蓝三个波段,对应的地面标注只有建筑物和非建筑两种类别。

|

|

|

DREAMB↓(1.2m) | DREAMB (0.3m) | 标签数据 (0.3m) |

|

|

|

马萨诸塞州建筑物↓(4m) | 马萨诸塞州建筑物(1m) | 标签数据 (1m) |

图2 数据集情况展示,其中↓代表下采样 | ||

(二) 方法介绍

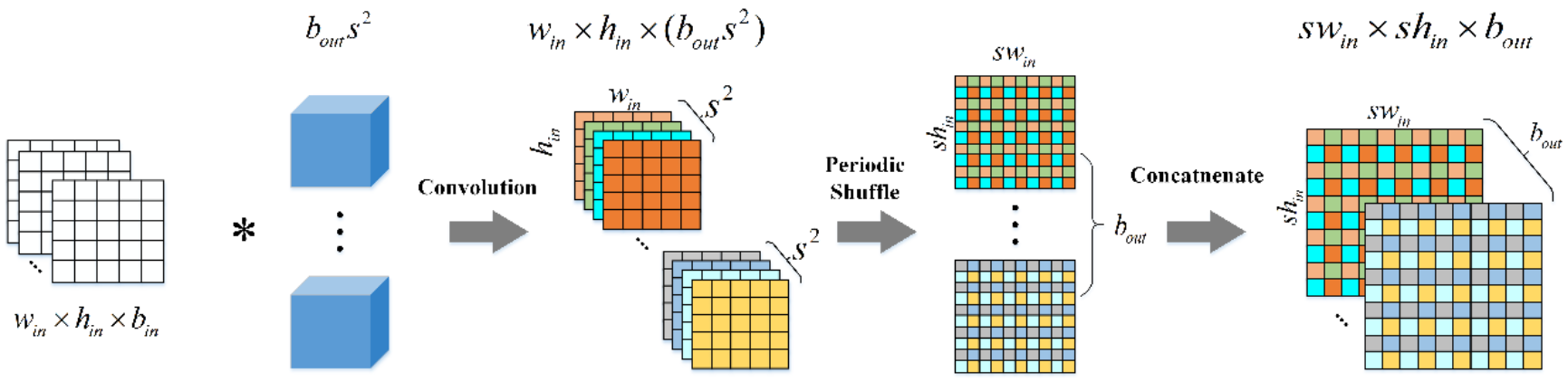

ESPC_NASUnet由两部分组成,按照位置将其称作前置组件和后置组件。在该方法中,我们在ESPCN网络的基础上设计了ESPC模块作为前置组件,它的作用是提升特征的空间分辨率。整个ESPC模块主要由三层卷积构成,前两层为普通卷积,卷积核大小均为![]() 。最后一层是特殊的高效子像素卷积,包括了卷积和像素重排的操作,工作流程如图3所示。通过该模块,特征的空间信息先被存储在频道维度,然后再通过重排恢复到空间维度。

。最后一层是特殊的高效子像素卷积,包括了卷积和像素重排的操作,工作流程如图3所示。通过该模块,特征的空间信息先被存储在频道维度,然后再通过重排恢复到空间维度。

图3 子像素卷积的流程,*代表卷积操作

紧接着ESPC模块的后置组件是一个语义分割模块,它是在语义分割网络Unet的基础上改进而来。这一部分的主体部分主要来至网络结构搜索网络NAS,如reduction cell和normal cell。它们主要是由恒等层,不同卷积核的深度可分离卷积层以及不同窗口大小的最大池化和均值池化层组成。经过NAS结构改造后的Unet网络有着更强的语义分割能力,以它为原型的NASUnet模块可以提升超分辨率语义分割的效果。

ESPC_NASUnet的整体结构如图4,输入数据首先通过特征超分辨率模块进行空间分辨率的扩张,再进入到语义分割模块进行像素级的类别预测。特征超分辨率模块前置能够有效保证靠近输入端的低级别细节信息得到保存,从而使得语义分割结果更为精细。

图4 ESPC_NASUnet,normal cell和reduction cell的具体结构。![]() 分别代表前一层之前的那一层输出,前一层输出以及当前层输出

分别代表前一层之前的那一层输出,前一层输出以及当前层输出

(三) 实验结果

(1) 与其他端到端SRSS结果对比

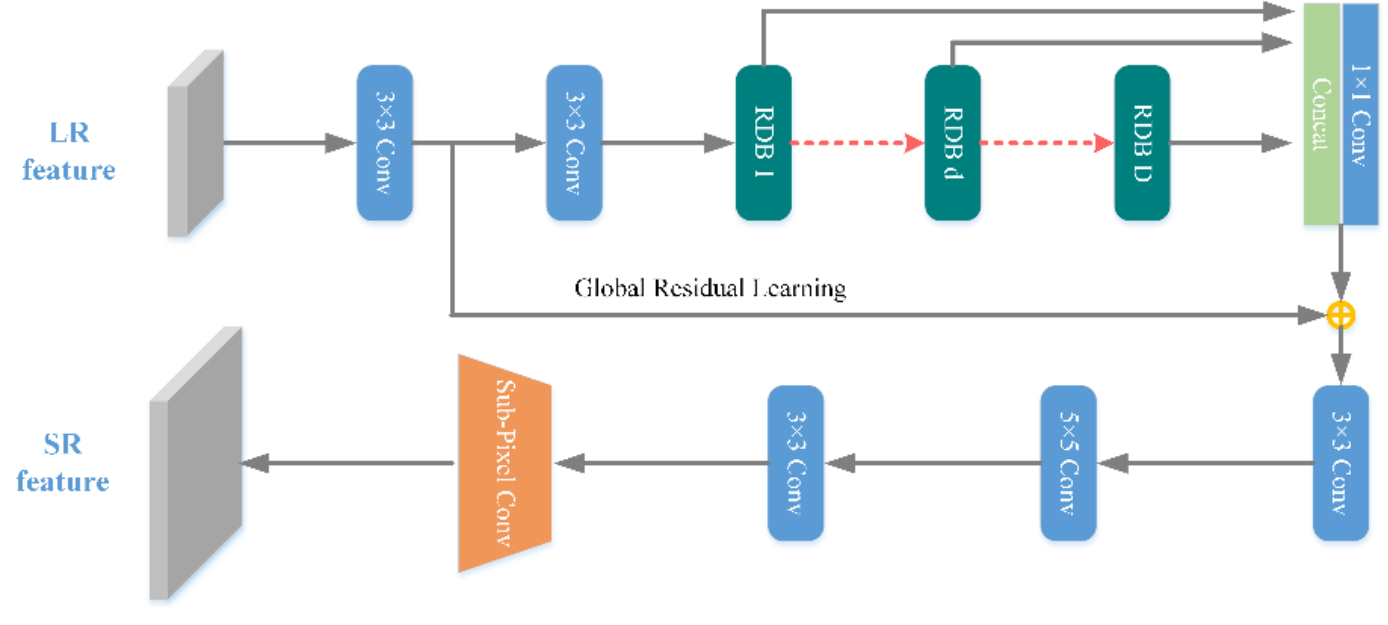

除了ESPC,我们还选择了另外一种更为复杂的特征超分辨率模块RDSR,同时通过调换特征超分辨率模块和语义分割模块的位置,构建出其他三种不同的端到端SRSS结构。其中RDSR的结构如下:

图5 RDSR网络结构

表1 不同端到端超分辨率语义分割方法像素级评价结果

Datasets | Methods | OA | Recall | Precision | F1-score | IoU | Kappa |

DREAMB | RDSR_NASUnet | 0.8443 | 0.6515 | 0.7403 | 0.6931 | 0.5303 | 0.8640 |

NASUnet_RDSR | 0.8244 | 0.5090 | 0.7614 | 0.6101 | 0.4390 | 0.8353 | |

NASUnet_ESPC | 0.8530 | 0.6871 | 0.7477 | 0.7161 | 0.5578 | 0.8733 | |

ESPC_NASUnet | 0.8837 | 0.7850 | 0.7842 | 0.7846 | 0.6456 | 0.9023 | |

马萨诸塞州建筑物 | RDSR_NASUnet | 0.8712 | 0.4525 | 0.7577 | 0.5666 | 0.3953 | 0.4965 |

NASUnet_RDSR | 0.8573 | 0.3293 | 0.7739 | 0.4620 | 0.3004 | 0.3948 | |

NASUnet_ESPC | 0.8494 | 0.2758 | 0.7634 | 0.4053 | 0.2541 | 0.3401 | |

ESPC_NASUnet | 0.8900 | 0.4864 | 0.8627 | 0.6221 | 0.4515 | 0.5635 |

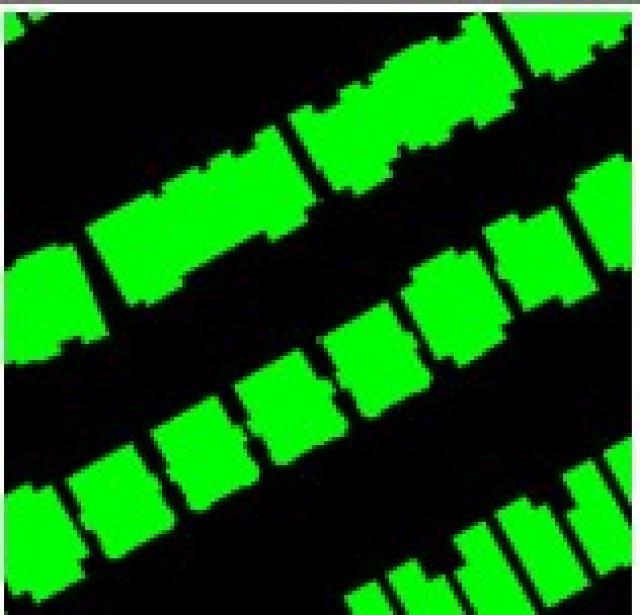

不同方法的像素级精度如表1所示,可以看到ESPC_NASUnet在两个数据集上均取得了最高的指标值,优于其他端到端语义分割方法。这四种网络的超分辨率语义分割效果如图6,可以看到ESPC_NASUnet取得了最优的效果,尤其是在分辨率更低的马萨诸塞州数据集上。

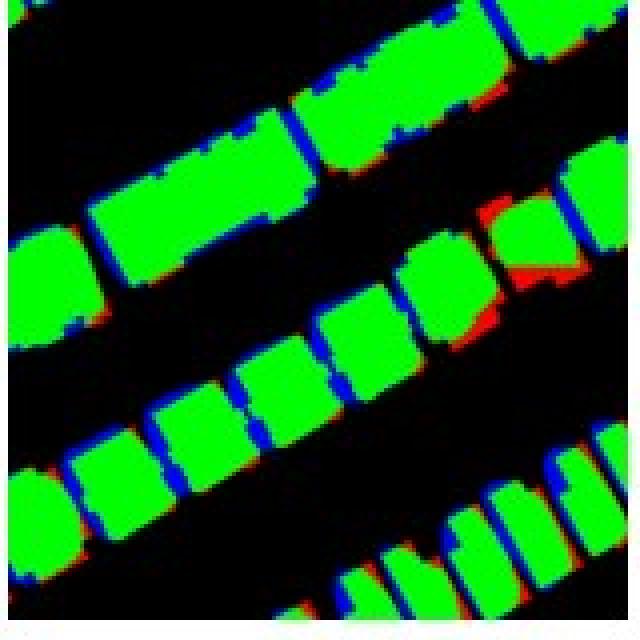

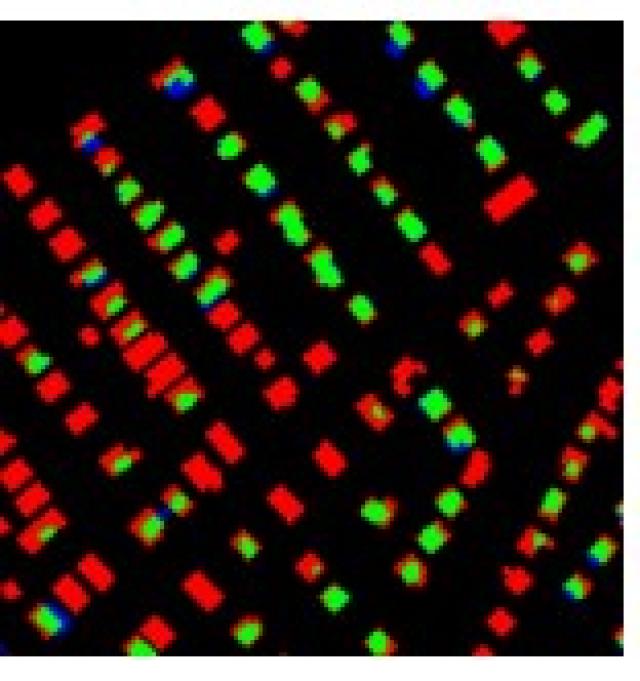

真实标签 | RDSR_NASUnet | NASUnet_RDSR | NASUnet_ESPC | ESPC_NASUnet |

|

|

|

|

|

(a) DREAMB | ||||

|

|

|

|

|

(b) 马萨诸塞州建筑物 | ||||

图6 不同端到端SRSS的结果 | ||||

(2) 与分阶段的方法进行对比

分阶段方法是直觉上最能完成从低分辨率数据到高分辨率语义分割结果提取的一种方法,为此我们选择了三种图片超分辨率方法(BiCubic, ESPCN, RDN)对低分辨率数据进行了预处理,之后再用训练好的高分辨率语义分割模型(HR-Net)进行预测。ESPC_NASUnet与各种端到端结果对比如表2,可以看到在DREAM-B数据集上,由于下采样的影响相对较小,RDN方法能够更好地恢复建筑物细节,因此RDN+HR-Net的方法表现较好。然而对于分辨率较低的马塞诸塞州数据集,下采样的信息损失较大,直接使用分阶段的方法无法得到与端到端方法相当的结果。

表2分阶段超分辨率语义分割与端到端方法像素级结果对比。(括号中的值为当前精度与ESPC_NASUnet对应精度值的差值,超过部分已加粗)

`Datasets | Methods | Pixel-level metrics | |||||

OA | Recall | Precision | F1-score | IoU | Kappa | ||

DREAM-B | LR-Net+Nearest | 0.8730 | 0.7041 | 0.8012 | 0.7495 | 0.5994 | 0.8891 |

BiCubic+HR-Net | 0.8541 | 0.5794 | 0.8283 | 0.6819 | 0.5173 | 0.8646 | |

RDN+HR-Net | 0.8927 | 0.7644 | 0.8251 | 0.7936 | 0.6578 | 0.9077 | |

ESPCN+HR-Net | 0.8861 | 0.7174 | 0.8371 | 0.7726 | 0.6295 | 0.8998 | |

马萨诸塞州建筑物 | LR-Net+Nearest | 0.8308 | 0.1493 | 0.7183 | 0.2472 | 0.1410 | 0.1957 |

BiCubic+HR-Net | 0.8443 | 0.1793 | 0.9184 | 0.3000 | 0.1765 | 0.2547 | |

RDN+HR-Net | 0.8460 | 0.1929 | 0.9029 | 0.3178 | 0.1889 | 0.2700 | |

ESPCN+HR-Net | 0.8406 | 0.1586 | 0.9133 | 0.2703 | 0.1563 | 0.2278 | |

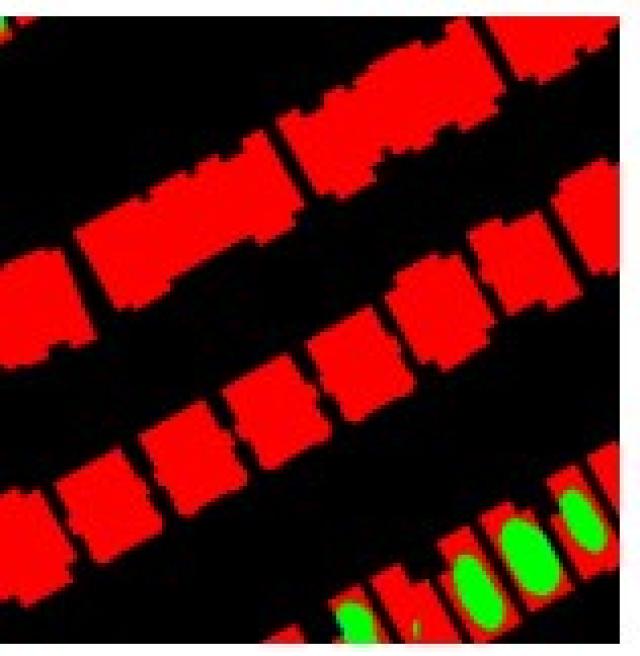

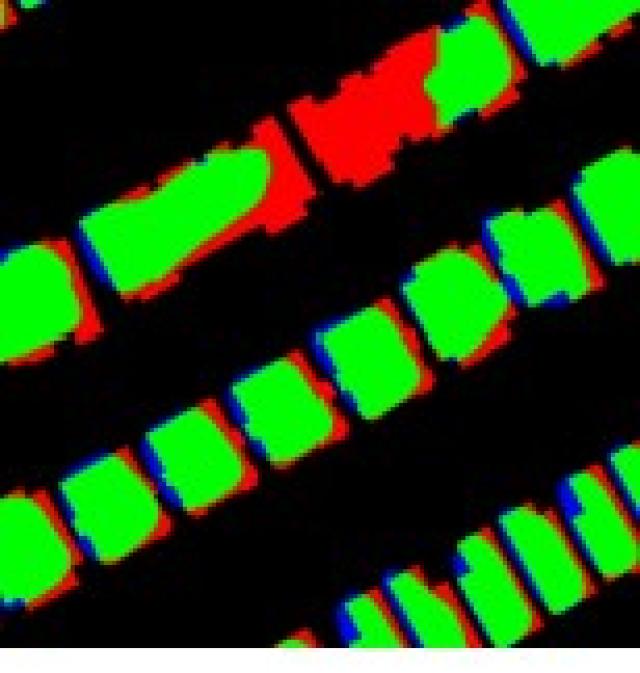

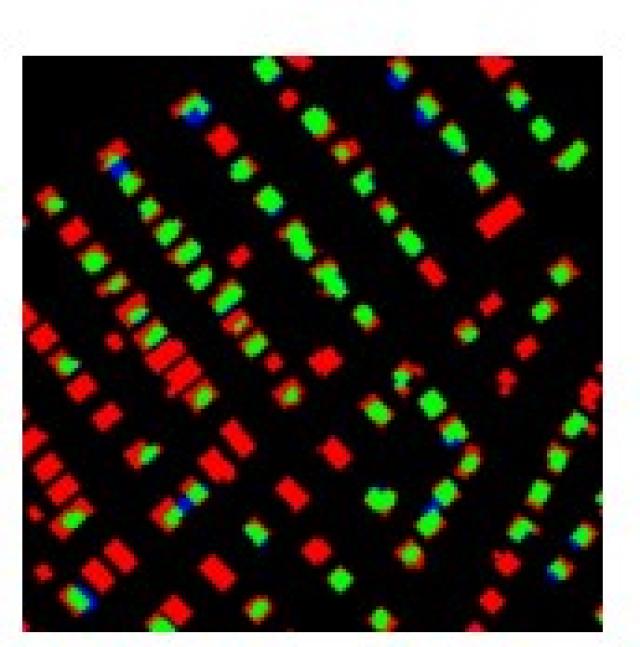

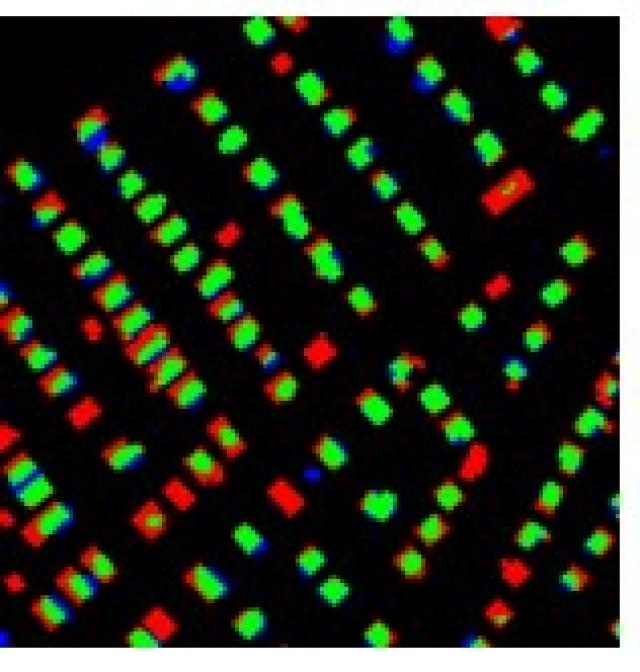

不同方法的建筑物提取结果如图7所示。对于较高分辨率的DREAM-B数据集,使用图片超分辨率的方法可以对其进行有效复原,也就能够得到更好的语义分割结果,而对于分辨率更低的马萨诸塞州数据集,显然ESPC_NASUnet的效果要优于分阶段方法。

|

|

|

|

|

(a) DREAM-B(原数据) | (b) BiCubic | (c) ESPCN | (d) RDN |

|

|

|

|

|

|

(e) 真实标签 | (f) BiCubic+HR-Net | (g) ESPCN+HR-Net | (h) RDN+HR-Net | (i) ESPC_NASUnet |

|

|

|

|

|

(j) 马萨诸塞州建筑物(原数据) | (k) BiCubic | (l) ESPCN | (m) RDN |

|

|

|

|

|

|

(n) 真实标签 | (o) BiCubic+HR-Net | (p) ESPCN+HR-Net | (q) RDN+HR-Net | (r) ESPC_NASUnet |

图 7 分阶段方法和ESPC_NASUnet的语义分割结果,其中绿色的为正确预测,红色为漏检,蓝色为误检。 | ||||

(3) 在哨兵2号数据上的验证

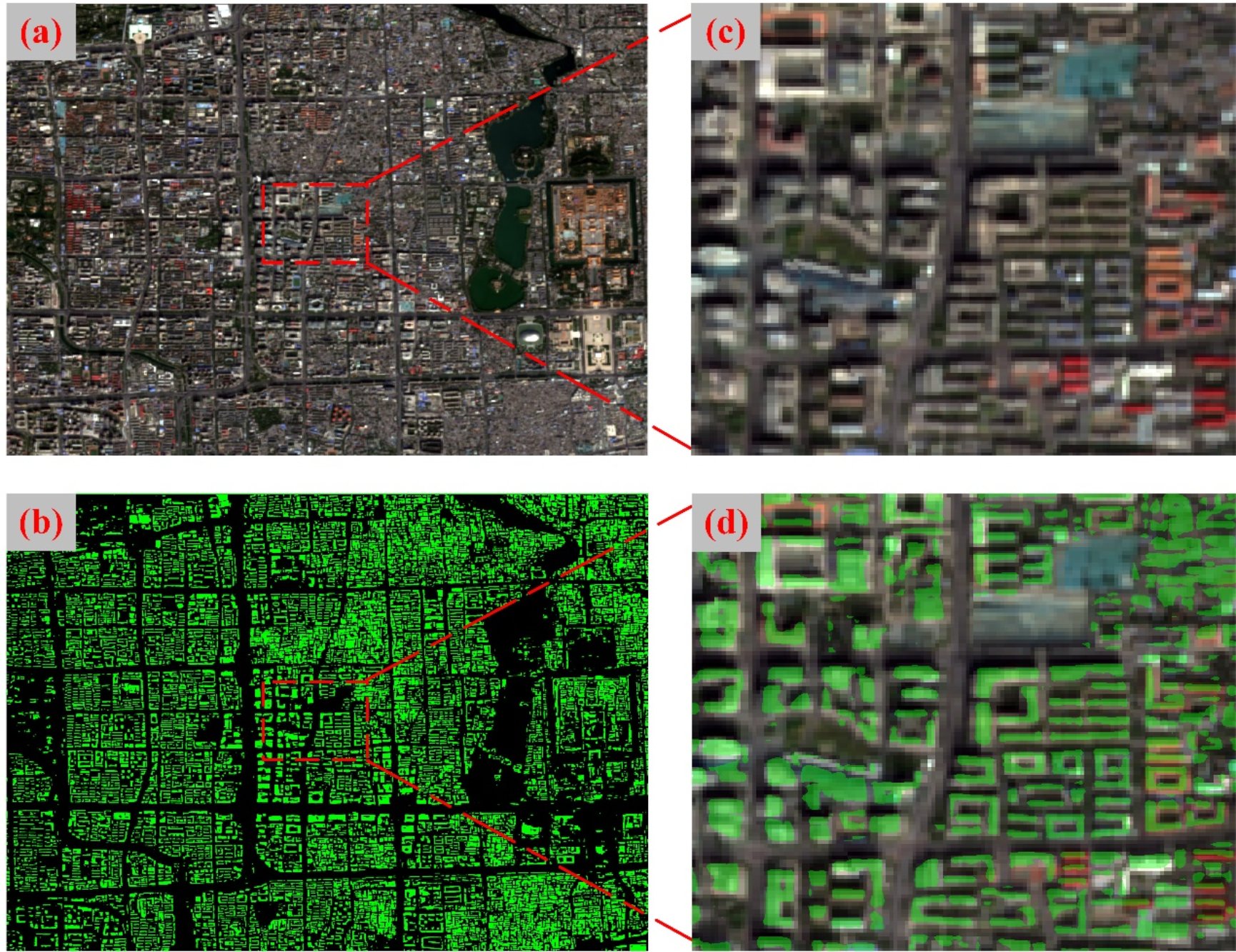

哨兵2号是一种公开获取的数据,最高空间分辨率为10米,因此我们将其作为验证所提方法实用性的数据。使用ESPC_NASUnet得到的超分辨率语义分割结果如图8,可以看到即使是使用10米级别的遥感影像,ESPC_NASUnet也能进行单栋建筑物级别的识别。

图8 ESPC_NASUnet在哨兵2号数据上的预测结果

(四) 讨论与结论

我们在图片超分辨率和语义分割技术启发下,提出了一种端到端的超分辨率语义分割网络,它能够有效地建立低分辨率数据和高分辨率语义图之间的映射关系。通过实验可以得到的主要结论如下:(1)前置的特征超分辨率模块有利于提升端到端SRSS的效果;(2)特征超分辨率模块不需要很高的复杂度也能取得很好的结果;(3)提出的ESPC_NASUnet能够有效地进行单栋建筑物级别的建筑物语义信息的提取。

由于该论文是建筑物超分辨率语义分割的首次尝试,目前仍然还存在较大的改进空间。与直接进行高分辨率语义分割得到的结果相比,所提出的方法仍然有一定的差距,这也是我们之后的改进方向。

参考文献:

Penglei Xu, Hong Tang, Jiayi Ge and Lin Feng, "ESPC_NASUnet: An End-to-end Super-Resolution Semantic Segmentation Network for Mapping Buildings from Remote Sensing Images," in IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, doi: 10.1109/JSTARS.2021.3079459.